Knapp zwei Dutzend Patienten in Deutschland und den USA haben bislang eine Sehprothese implantiert bekommen. Dazu öffnen Mediziner den Augapfel und befestigen auf der Netzhaut eine dünne Folie. Von ihr ragen haarfeine Kontakte an die Nervenzellen, die die obere Netzhautschicht bilden. Diese elektrischen Reizkontakte speisen die Kamera-Signale in den Sehnerv ein. Die Kamera ist beispielsweise an einer Brille befestigt und überliefert ihre Informationen drahtlos an die künstliche Netzhaut.

Die Ergebnisse erfüllen bislang nicht die hochgesteckten Erwartungen. "Die Kamera liefert elektrische Impulse, mit denen das Gehirn kaum etwas anfangen kann", erklärt Professor Dr. Rolf Eckmiller vom Bonner Institut für Informatik. "Unser Verfahren übersetzt die Kamerasignale in eine Sprache, die das Sehzentrum versteht." Doch leider spricht das Sehzentrum jedes Menschen einen anderen Dialekt - das macht die Dolmetscher-Leistung schwierig. Daher hat der Neuroinformatiker und Mediziner zusammen mit seinen Doktoranden Oliver Baruth und Rolf Schatten den "Retina Encoder" entwickelt. Für den Sprung in die medizinische Praxis sucht er auf der Hannover-Messe nach Industriepartnern.

Übersetzer in der Brille

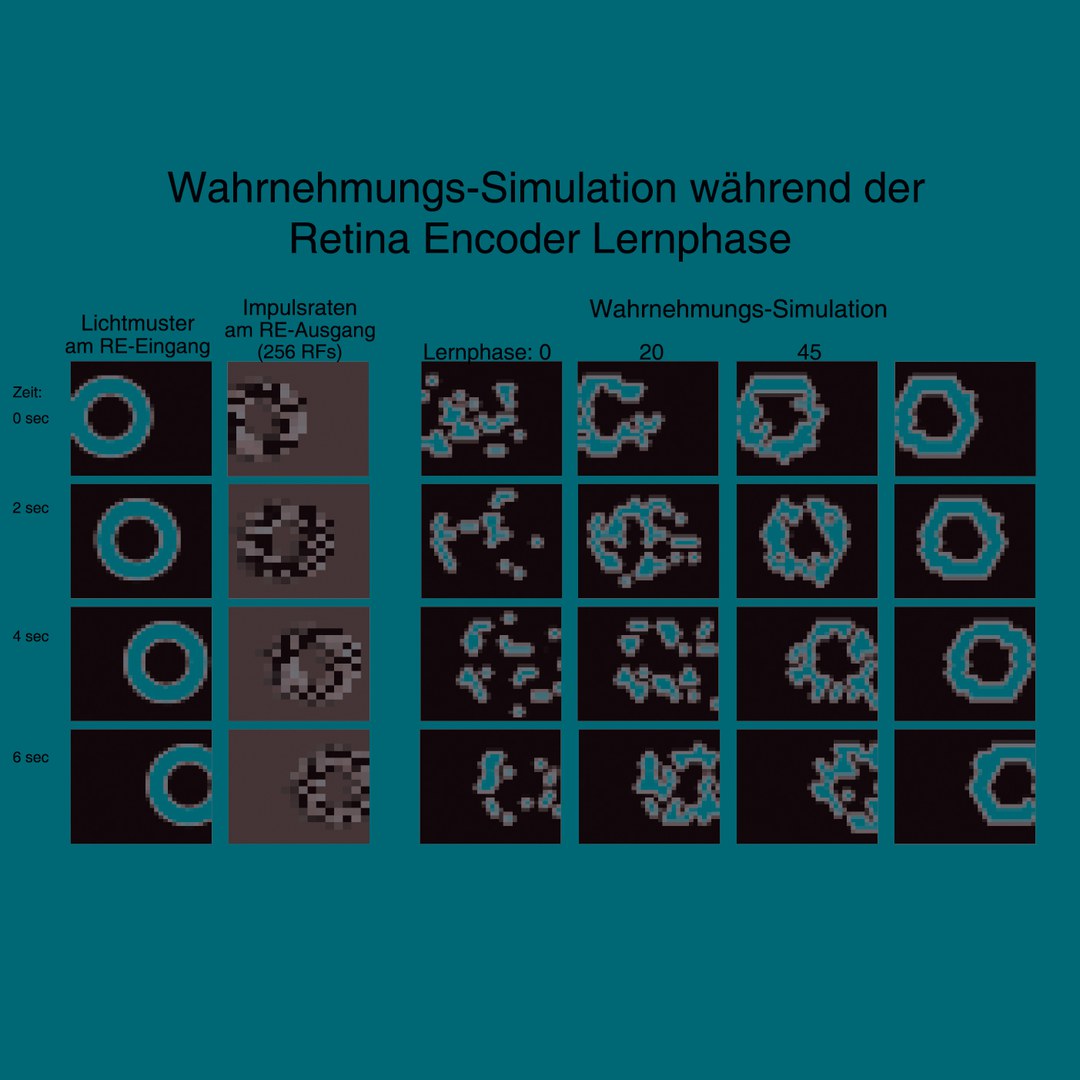

"Der Retina Encoder ist im Prinzip ein Computerprogramm, das die Signale der Kamera umwandelt und an das Netzhaut-Implantat weiter gibt", erläutert Oliver Baruth die Funktionsweise. "In einem kontinuierlichen Prozess lernt der Encoder, wie er das Kamerasignal verändern muss, damit der jeweilige Patient das Bild erkennen kann." Die Erprobung des Lern-Dialoges erfolgt gegenwärtig mit normalsichtigen Probanden. Die Kamerabilder werden dabei vom Retina Encoder übersetzt und dann an eine Art "virtuelles Sehzentrum": weiter gegeben. Dort wird simuliert, wie das Gehirn die umgewandelten Kameradaten interpretieren würde.

Der Retina Encoder weiß zunächst nicht, welche Sprache das virtuelle Sehzentrum spricht. Daher übersetzt die Software das Ausgangsbild - beispielsweise einen Ring - in verschiedene zufällig gewählte "Dialekte". Dabei entstehen Bildvarianten, die einem Ring mal mehr, mal weniger ähneln. Die Versuchsperson sieht diese Varianten auf einem kleinen Bildschirm, der in ein Brillengestell integriert ist. Per Kopfbewegung wählt sie die Versionen aus, die einem Ring am ähnlichsten sehen. Die lernfähige Software zieht daraus Rückschlüsse, wie sie die Übersetzung verbessern muss. Im nächsten Zyklus präsentiert sie darauf basierend mehrere neue Bilder, die dem Original schon ähnlicher sehen: Der Retina Encoder passt sich so schrittweise an die Sprache des virtuellen Sehzentrums an. Im Test funktioniert das auch sehr gut; an Patienten haben die Wissenschaftler ihr Verfahren jedoch noch nicht erprobt. Im Prinzip ließe sich der Encoder aber binnen weniger Monate in bereits implantierte Sehprothesen integrieren, betonen die Forscher.

Beim gesunden Menschen ist eine Art natürlicher Retina Encoder bereits in die Netzhaut integriert: Vor den Lichtsinneszellen liegen nämlich vier Schichten von speziellen Nervenzellen. "Die Netzhaut ist ein durchsichtiger Biocomputer", sagt Eckmiller. "Sie wandelt die elektrischen Impulse der Stäbchen und Zapfen in ein kompliziertes Signal um." Über den Sehnerv gelangt dieses Signal dann in das Gehirn.

Keine Wunder zu erwarten

Dort wird die komplexe Information entschlüsselt. Die Fähigkeit dazu erwirbt das Gehirn in den ersten Lebensmonaten. In dieser Zeit stellt sich das Sehzentrum individuell auf die Retina-Signale ein: Das Gehirn lernt, die vom Sehnerv gelieferten Daten zu interpretieren. Beim Erwachsenen, der im Laufe des Lebens erblindet, ist das Sehzentrum aber schon ausgereift: Es kann sich nicht mehr so einfach umstellen. "Wenn das Sehzentrum nicht mehr so flexibel ist, muss es die künstliche Netzhaut sein", betont Eckmiller: "Sie muss lernen, Signale zu liefern, mit denen das Gehirn etwas anfangen kann. Und genau diesen Lernvorgang leistet unser Retina Encoder."

Dennoch warnt er vor allzu hochgesteckten Erwartungen: "Niemand soll denken, er könne mit einer Sehprothese wieder seine Lieblingskrimis lesen. Er kann vielleicht die Gestalt grösserer Objekte erkennen und schemenhaft wahrnehmen; mehr ist auf absehbare Zeit nicht drin. Für einen Blinden bedeutet das aber einen riesigen Fortschritt: Er kann sich wieder in seiner Umgebung orientieren. Dieser Gewinn an Eigenständigkeit ist unser Ziel!"

Ansprechpartner:

Professor Dr. Rolf Eckmiller

Institut für Informatik VI der Universität Bonn

Telefon: 0228/73-4422

E-Mail:

eckmiller@nero.uni-bonn.de

http://www.nero.uni-bonn.de

1

Weiterführende Informationen:

This press release in English

2

Bilder zu dieser Pressemitteilung:

Zum Download einer Bilddatei in Originalauflösung bitte auf die Miniaturansicht klicken. Der Abdruck im Zusammenhang mit der Presseinformation ist kostenlos, dabei ist der angegebene Bildautor zu nennen.

Stefan Borbe sieht die Bilddaten aus dem "virtuellen Sehzentrum" auf dem Brillendisplay. Foto: AG Eckmiller / Uni Bonn

Foto: Frank Luerweg / Uni Bonn

Sebastian Sachs (links) trainiert Stefan Borbe. Nach einigen Lernzyklen kann Borbe Sichel und Kreis sicher voneinander unterscheiden. Foto: Frank Luerweg / Uni Bonn

Lernvorgang des Retina Encoders. In der Spalte links ist das ringförmige Eingangssignal zu sehen, das sich langsam von links nach rechts bewegt. Die vier Spalten rechts zeigen, wie das virtuelle Sehzentrum die Bilder wahrnimmt. Grafik: AG Eckmiller

Lernende Sehprothese auf der Hannover-Messe Lernende Sehprothese auf der Hannover-Messe

Bonner Informatiker zeigen ein Verfahren, das die Leistung von Netzhaut-Implantaten deutlich verbessert

Als die Idee vor einigen Jahren aufkam, klang sie bestechend: Man könnte doch in die geschädigte Netzhaut von Blinden Elektroden implantieren und daran eine Minikamera anschließen, um so das Sehvermögen wieder herzustellen. Mit den ersten klinischen Tests kam jedoch die Ernüchterung: Die Patienten konnten nach der Operation nicht einmal einfache Formen voneinander unterscheiden. Neuroinformatiker der Universität Bonn stellen auf der Hannover-Messe eine Software vor, die das ändern soll: Mit ihr "lernt" die Sehprothese, genau die Signale zu liefern, die das Gehirn erwartet und interpretieren kann. Die lernende Sehprothese ist vom 16. bis 20. April auf dem Gemeinschaftsstand der Wissenschaftsregion Bonn zu sehen (Halle 2, Stand D35).

Bild Lernende Sehprothese auf der Hannover-Messe

© Universität Bonn

Alle Bilder in Originalgröße herunterladen

Der Abdruck im Zusammenhang mit der Nachricht ist kostenlos, dabei ist der angegebene Bildautor zu nennen.

Links

- http://www.nero.uni-bonn.de

- http://www.uni-bonn.de/en/News/88_2007.html

- https://www.uni-bonn.de/de/universitaet/presse-kommunikation/presseservice/archiv-pressemitteilungen/2007/symbiose-von-leidenschaft-und-beruf

- https://www.uni-bonn.de/de/universitaet/presse-kommunikation/presseservice/archiv-pressemitteilungen/2007/nachrichtenverschlusselung-per-fingerabdruck